När och om du uppdaterar din iPhone, iPad, Apple Watch eller Mac till iOS 15, iPadOS 15, watchOS 8 respektive macOS Monterey i höst kommer en helt ny funktion som Apple har utformat för att bekämpa barnpornografi och barnmisshandel. Tyvärr verkar det som priset du får betala för att skydda barnen betyder farväl till integriteten.

Tekniken som Apple annonserade för någon dag sedan, screenar så att säga, innehållet i din Apple-enhet efter kända barnpornografibilder. Liknande teknik har länge implementerats i tjänster som Gmail, Twitter, Facebook och Dropbox, men Apple har hittills vägrat använda liknande teknik eftersom det skulle undergräva end-to-end-kryptering och därmed skydd av användarnas data, som hittills har varit en av Apples kärnprinciper.

Men som alla andra vill Apple naturligtvis skydda minderåriga från övergrepp och bekämpa spridningen av barnpornografi, och därför har teknikjätten nu utvecklat sin egen lösning, som enligt Apple själv gör det möjligt att screena efter olagliga bilder utan att äventyra användarsäkerheten.

Meddelanden, foton och Siri

Apples initiativ består av tre separata funktioner.

1) Foton: Det amerikanska ”National Center for Missing and Exploited Children” (NCMEC) har en databas med kända barnpornografibilder. Databasen innehåller en så kallad hashtabell, där varje enskild bild har tilldelats ett unikt hashvärde, som beräknas utifrån data i den bilden.

All befintlig screeningteknik, inklusive Microsofts PhotoDNA, fungerar genom att låta tjänsten skanna och analysera alla bilder av alla användare. En bild som är identisk med en bild i barnpornografidatabasen består av identiska data och kommer därför också att ha samma hashvärde, varefter det finns en ”träff” i databasens hashtabell.

Om du skickar ett e-postmeddelande med en bifogad bild till någon med Gmail eller laddar upp en bild till Facebook, måste bildfilen alltid först gå igenom ett filter som beräknar hashvärdet för bilden och jämför den med databasen för att säkerställa att den är inte barnpornografi.

Men den lösningen fungerar inte om tjänsten i fråga använder end-to-end-kryptering, för då är det inte möjligt att skanna innehållet. Och det är därför Apple har valt att implementera sitt screeningsystem direkt på användarens iPhone, iPad, MacBook, etc.

Från nästa uppgradering av Apples databas lagras hashtabellen från NCMECs databas helt enkelt lokalt på användarens enhet och alla foton som lagras på enheten och/eller laddas upp till iCloud kommer att skannas.

På så sätt får Apple inte direkt åtkomst till användarens filer, men varje godkänd bild tilldelas en krypterad så kallat ”säkerhetsbevis”, och bara om ett visst antal bilder (det exakta antalet är okänt) har gett ”träffar” i hashtabellen och därmed har identifierats som barnpornografi, kan Apple öppna krypteringen och komma åt användarens bilder.

Naturligtvis kommer Apple då att polisanmäla ägaren av de olagliga bilderna.

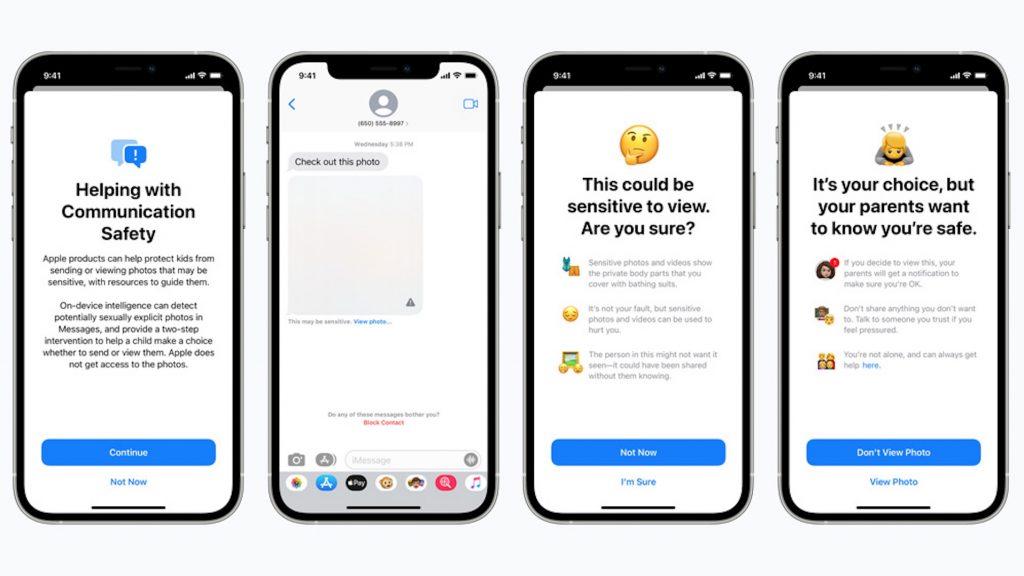

2) Meddelanden: Förutom att ständigt övervaka alla Apple-användares enheter för känt barnpornografiskt material kommer Apple också att hindra minderåriga användare från att använda företagets egen end-to-end-krypterade chattapp, iMessage (Messaging på engelska) för att skicka eller ta emot bilder med sexuellt innehåll.

Den här funktionen kommer inledningsvis bara att gälla för amerikanska användare, men avsikten är, enligt Apple, att skydda barn mot sexuella övergrepp globalt.

Apple förklarar inte i detalj hur den nya funktionen fungerar tekniskt. Företaget skriver helt enkelt i ett white paper att iMessage kommer att utökas med machine learning – en slags artificiell intelligens – som fungerar på användarens enhet och analyserar alla bifogade bildfiler för att avgöra om de är av sexuell natur eller inte. Funktionen kommer endast att aktiveras för yngre användare som definieras som sådana i iCloud Family Sharing.

Återigen har Apple inte direkt åtkomst till meddelanden eller bilder, men om en bifogad bild kategoriseras som stötande blir den suddig och den minderåriges föräldrar automatiskt meddelas om barnet är under 13 år.

3) Siri: Sist men inte minst kommer både Siri och Apple-enheters inbyggda sökfunktion att ändras så att en sökning efter ord som ”barnporr” kommer att utlösa en varning samt råd om var du kan söka hjälp.

FUCK Apple

FUCK dem 1.000 gange@infosecholsta jeg glæder mig til at se om du stadig kører Apple iPhone på BornHack 😛

— Henrik Kramselund Pfizer 2of2 🏳️🌈 (@kramse) August 6, 2021

Syftet är gott, men Apples beslut är en katastrof

Apple har helt klart ansträngt sig för att utrusta sina enheter med en hög barnsäkerhet utan att äventyra den enskilda användarens säkerhet.

Till skillnad från de ovannämnda tjänsterna som Facebook, Google, Dropbox, etc., som inte alls döljer att de naturligtvis har tillgång till all din data, har Apple under ett antal år lagt stor vikt vid att användarnas data tillhör dem själva och inte når andra. Och då inte ens Apple.

Och tekniskt sett verkar Apples lösning elegant, eftersom företaget verkligen bara får tillgång till dina bilder och andra data om det finns flera träffar i databasen över kända barnporrbilder, och så långt som nakenbilder eller sexuellt explicita bilder i chattar, där minst en som deltar är minderårig, meddelas bara barnets föräldrar.

Men så vitt jag vet är Apples nya satsningar i själva verket en katastrof för integriteten. Och det säger jag inte för att jag vill förhindra att barn misshandlas på något sätt. Jag säger detta eftersom Apples lösning på vissa sätt faktiskt är mycket mer påträngande än lösningarna, som t.ex. Google, Facebook och Dropbox använder sig av. Och med det har Apple öppnat dörren för systematisk undergrävning av datasäkerhet och användarnas rätt att bestämma vem som har tillgång till deras data.

Apple plans to modify iPhones to constantly scan for contraband:

“It is an absolutely appalling idea, because it is going to lead to distributed bulk surveillance of our phones and laptops,” said Ross Anderson, professor of security engineering. https://t.co/rS92HR3pUZ

— Edward Snowden (@Snowden) August 5, 2021

En balansgång

Det avgörande här är att med den nya tekniken har Apple i praktiken byggt in en välfungerande bakdörr i alla sina användares fysiska enheter.

Eftersom tekniken – även i sekretessens heliga namn – inte bara koncentrerar sig på den data du väljer att skicka till andra eller placerar i molnet via Internet, utan faktiskt fungerar lokalt på din egen enhet, har Apple i princip fått tillgång till ALL din data. Allt du har på din mobil, surfplatta eller dator åtminstone. Varsomhelst och närsomhelst.

Och även om syftet är gott hindrar inte så kallat mission creep, där en teknik som initialt implementeras med ett specifikt ändamål som alla kan gå med på att stödja, sedan förändras för att användas för andra ändamål.

Apples produkter säljs över hela världen. Även i länder som Kina, där Apple under press från den kinesiska regeringen redan har släppt på sina egna principer och lagrat känslig kundinformation från kinesiska användare på servrar i ett datacenter under kontroll av den kinesiska regeringen. Precis som företaget också har tagit bort t.ex VPN-appar och Appstore eftersom de kinesiska myndigheterna krävde det.

Det krävs inte mycket fantasi för att föreställa sig att den teknik som Apple nu gör en integrerad del av alla sina operativsystem kan missbrukas av regeringar som t.ex. vill leta efter användare som har bilder på olagliga politiska slagord på sin mobiltelefon. Ett mycket realistiskt scenario t.ex. i Hong Kong.

Ett filter som letar efter sexuellt explicita bilder av minderåriga kan justeras lite för lätt så att det kan användas i jakten på homosexuella i det ganska stora antalet länder där homosexualitet fortfarande är straffbart.

Och så vidare och så vidare.

Om du inte tror att Apple någonsin kommer att tillåta att deras teknik missbrukas, påminner jag dig igen om hur Apple hjälper den kinesiska regeringen att utöva censur och ger de kinesiska myndigheterna tillgång till data om politiskt förföljda kinesiska medborgare.

Just to state: Apple’s scanning does not detect photos of child abuse. It detects a list of known banned images added to a database, which are initially child abuse imagery found circulating elsewhere. What images are added over time is arbitrary. It doesn’t know what a child is.

— SoS (@SwiftOnSecurity) August 5, 2021

Falsk marknadsföring

Att Apple säkert kommer att fortsätta marknadsföra sina produkter och tjänster som end-to-end-krypterade, medan företaget faktiskt har integrerat ett sofistikerat och effektivt övervakningssystem i alla sina produkter, gör mig inte lättare till mods

Speciellt inte eftersom Apples hycklande försöker väcka förtroende hos sina användare, vilket de, tvärtemot vad de säger, verkligen undergräver genom att införliva systemnivåövervakningsprogram i alla användares enheter. Jag menar, litar du verkligen på Apple så mycket att du tycker att det är okej att din mobil eller dator är utrustad med teknik som kan analysera alla dina foton?

Inte ens en teknik som utvecklats för en god sak motiverar underminering av användarnas rätt till integritet.